편집자주

가속화한 인공지능 시대. 인간 모두를 위한, 인류 모두를 위한 AI를 만드는 방법은? AI 신기술과 그 이면의 문제들, 그리고 이를 해결할 방법과 Good AI의 필요충분조건

게티이미지뱅크

지난 칼럼에 이어 인공지능 윤리의 5대 문제 중 AI 편향성 문제 사례와 바람직한 해결 방안을 살펴보고자 한다. 2016년 미국 탐사보도매체 ‘프로퍼블리카’는 미국 내 많은 법원에서 사용 중인 AI 재판 지원시스템 컴파스(COMPAS)에 대한 기사를 보도했다.

컴파스는 피고인의 데이터를 종합하여 재범 가능성을 예측하는 인공지능인데, 프로퍼블리카의 보도에 따르면 컴파스를 통하여 미국 플로리다에서 체포된 범죄자 1만 명을 대상으로 재범가능성을 예측해보았더니 흑인의 재범 가능성이 백인보다 2배 이상 높게 나타났다는 것이다. 하지만 실제 현실에서는 흑인의 재범률이 백인보다 더 높지 않았다.

인공지능 컴파스는 왜 이런 잘못된 예측을 했을까? ‘MIT 테크놀로지 리뷰’에 따르면, 실제 사례에서 흑인 피고와 백인 피고와의 검거율 차이가 그 원인임을 밝혀냈다. 곧 실제 흑인 피고는 52%가 체포됐지만, 백인 피고는 39%만이 체포됐다는 것이다.

이 같은 결과는 인공지능은 죄가 없다는 것을 보여준다. 인공지능은 학습을 위해 제공받은 데이터들을 토대로 판단했을 뿐, 데이터 자체가 편향되어 있었기 때문이다. 오히려 컴파스 사례는 데이터의 편향도 결국 사회 구조와 사회 문화의 편향(?) 때문이라는 점을 시사하고 있다.

2018년에는 글로벌 기업 아마존에서 인공지능 채용 프로그램 논란이 있었다. 아마존에서 AI 채용 프로그램을 개발했는데, 실제 적용하기 전 최종 시뮬레이션 과정에서 남성 지원자가 여성 지원자보다 지속적으로 더욱 높은 점수를 받는 편향이 일어났다.

원인을 분석했고, 아마존이라는 기업의 직원 구성에 그 원인이 있었다. 인공지능 채용 프로그램은 해당 기업에서 높은 성과와 좋은 평가를 받았던 직원들의 데이터를 기준으로 판단하게 되는데, 아마존은 IT 기업으로써 개발직군이 전체 직원수의 70% 이상을 차지했고, 그러한 개발직군 중 남자 직원수가 여성보다 압도적으로 많았기 때문이다.

결국 모수에서 남성 직원 중에 고성과자가 훨씬 더 많을 수밖에 없었으므로 이를 근거로 판단한 인공지능은 당연히 남성 지원자를 우대할 수밖에 없었던 것이다. 결국 아마존은 데이터를 수정하거나 알고리즘을 고치는 것만으로는 한계가 있다고 판단하여 해당 AI 채용 프로그램을 폐기했다.

우리나라에서도 작년 9월, 국회 교섭단체 대표연설 관련 기사가 한 포털사이트에서 정당에 따라 편향적으로 노출되었다고 한 국회의원이 주장하면서 AI 편향성 논란이 일었다. 해당 포털사이트는 메인페이지의 뉴스 섹션 편집은 인공지능이 하고 있기 때문에 인간의 개입은 없다고 항변했다.

하지만 위의 세 가지 사례를 통해 본 것처럼, 인간과 사회 구조, 사회 문화에 따라 데이터가 편향될 수밖에 없다면, 인공지능 역시 편향될 수밖에 없다. 따라서 현재 인공지능 기술 수준에서 완벽한 인공지능, 완벽한 알고리즘을 기대하는 것보다는 그 한계점을 먼저 인정하는 것이 출발점이 된다.

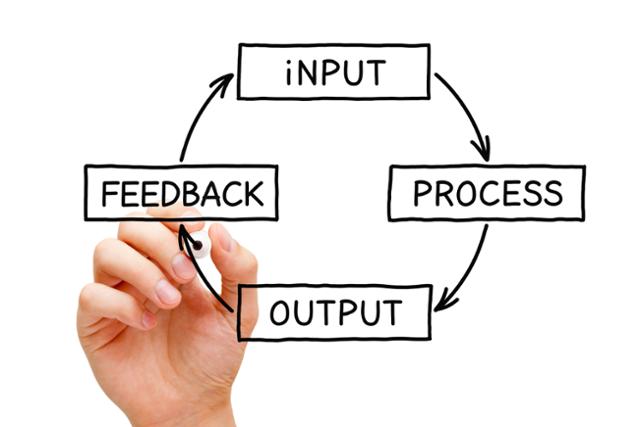

그리고 우리는 AI 편향성을 기획부터 출시, 운영과정까지 지속적으로 검증하고, 보완하고, 또 검증하고, 보완할 수밖에 없다. 결과에 대해 충분한 시뮬레이션을 반복하고 그렇게 검증 과정에서 나온 오류들을 수정하고, 또다시 시뮬레이션하고 그 결과를 다시 검증하고 보완하는 절차를 반복해야 한다.

물론 이러한 작업은 AI 스타트업들이 하기에는 쉽지 않다. 그래서 정부와 기업, 유관기관들이 협력하여 이러한 AI 편향성을 테스트하고 검증할 수 있는 시스템을 개발, 보급하는 것이 필요하다. 또한 그러한 편향성을 검증하고 가이드할 수 있는 중립적인 기구를 설치하여 우리 기업들을 지원하는 것도 좋은 방안이 될 것이다.

기사 URL이 복사되었습니다.

댓글0