카메라·레이더·라이다 ‘센서 3형제’

다양한 센서가 작동하는 자율주행차. 게티이미지뱅크

인간의 외부 자극은 오감(시각·청각·후각·미각·촉각)으로부터 수용된다. 이 자극은 전기 신호를 통해 중추신경계로 전달되고, 이를 통해 사고하고 행동한다. 자율주행차는 전통적인 차량과 달리 인간처럼 사고하고 스스로 운행해야 한다. 자율주행차의 운행 원리도 인간이나 동물의 사고 과정과 유사하다. 인간이 신경세포(뉴런)로부터 감각을 느끼듯, 자동차도 기본적으로 탑재된 센서들이 주변 환경 요소를 인식한다. 차량 내 인공지능(AI) 컴퓨터(PC)는 센서에서 수집한 정보로 차량을 제어한다. 이 제어기가 자동차의 각 부품에 명령을 내리면, 마치 인간이 두 발로 움직이듯 자동차도 스스로 움직인다.

이처럼 생각과 움직임의 근간은 감각기관을 통해 수집되는 정보다. 인간이 사고하고 행위하는 것도 두 눈으로 활자를 읽고, 귀로 음성을 듣기 때문이다. 때문에 정확한 정보 수집은 매우 중요하다. 수집된 정보가 부정확하면 이후 중추신경계의 판단과 이에 따른 움직임도 잘못될 가능성이 크기 때문이다. 자율주행차가 인간의 도움 없이 스스로 안전하게 운행하기 위해서 고도화된 감지 능력이 필요한 이유다.

자율주행차 핵심 센서…카메라·레이더·라이다

시각물_자율주행 센서 카메라·레이더·라이다 비교

자율주행차의 주변 환경 인식은 크게 카메라와 레이더, 라이다 등을 포함한 3개의 센서에서 시작된다. 인간의 눈, 코, 입, 귀의 역할이 다른 것처럼 각 센서의 전문 분야도 다르다. 우선 카메라 센서는 사람과 사물, 차량 등으로 분류하면서 주변 물체 식별에 사용된다. 다만 어두운 공간이나 악천후 상황에선 확실한 사물 식별이 어렵다. 카메라를 차선 인식 용도로만 이용했던 과거와는 달라진 모습이다. 이스라엘 카메라 알고리즘 업체인 ‘모빌아이’ 정도만 앞차와의 거리나 도달 시간 등을 이용해 운전자보조장치(DAS)를 상용화했다. 최근 들어선 테슬라와 현대모비스 등이 연석이나 자갈, 잔디를 인식하는 카메라 기술 개발에 성공해 양산 중이다. 평면에만 국한됐던 인식 기능이 돌출된 구조물 파악까지 가능해진 셈이다.

원래 군사목적으로 개발됐던 레이더의 경우엔 전자기파를 발사하고 반사돼 돌아오는 신호를 기반으로 주변 사물과의 거리, 속도, 방향 등의 정보를 추출하는 센서다. 또 날씨, 시간과 관계없이 제 성능을 발휘한다. 레이더는 주파수에 따라 단거리부터 중거리, 장거리를 모두 감지할 수 있다는 점에서 현재도 긴급자동제동장치, 스마트 크루즈 컨트롤 등 다양한 첨단운전자보조시스템(ADAS) 기술에 적용되고 있다.

자율주행차에서 레이더 센서가 작동하는 이미지. 현대모비스 제공

주파수는 긴 파장의 저주파일수록 상대적으로 동일한 출력의 전파를 쏘아도 도달 거리가 길어지는 반면 정확도는 떨어진다. 이런 특성으로 장거리 레이더 센서는 저주파인 77기가헤르츠(㎓) 대역을 사용한다. 보다 명확한 정보가 요구되는 단거리 레이더 센서의 대역폭은 79㎓ 대역을 이용한다. 장거리 레이더는 150~200m 이상까지 확인되지만 화각이 40도 안팎이다. 단거리 레이더의 경우엔 100m 이내 거리를 감지하지만 화각은 100도 이상이다.

라이다는 레이저(빛)를 물체와 주고받으며 3차원 지도를 만들어낸다. 주로 905나노미터(nm)의 짧은 파장을 이용해 레이더보다 공간 분해능력이 훨씬 정밀하다. 또 자체 광원으로 빛이 부족환 환경에서도 성능에 영향을 덜 받는다. 때문에 카메라, 레이더가 감지하지 못하는 환경에서도 활용할 수 있다. 최근에는 출력을 1,550nm까지 높여 훨씬 더 넓은 공간을 인식할 수 있는 기술도 개발됐다. 이는 사람 눈에 흡수되지 않고, 태양광의 간섭현상도 적어 안정성이 뛰어나다.

작동 방식이 사람의 눈과 유사한 라이다는 ‘자율주행차의 눈’으로 불린다. 사람은 왼쪽 눈과 오른쪽 눈 사이의 거리, 왼쪽 눈에서 보이는 물체와 오른쪽 눈에서 보이는 물체의 거리를 계산해서 실제 대상 물체와의 거리를 파악한다. 라이다는 초당 수십 번의 레이저를 주변 사물들과 주고받으면서, 정밀하게 거리 정보를 파악할 수 있다. 이는 자율주행 시스템의 신뢰를 높이는 데 중요한 역할을 한다. 다만 고가인 라이다의 경우, 빛을 이용하는 만큼 악천후 시 정확도가 떨어진다.

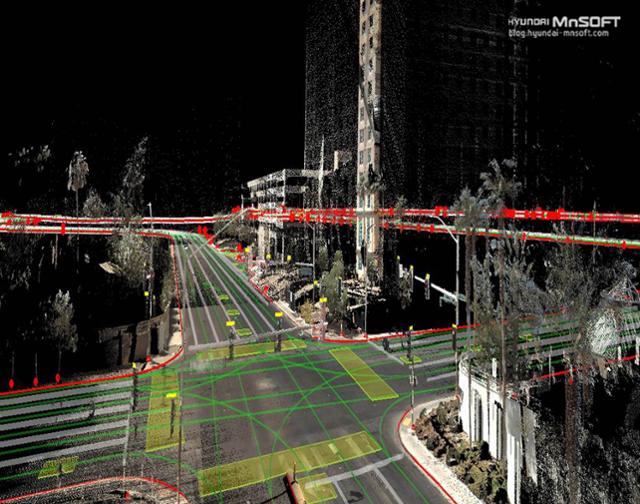

라이다 센서를 활용해 구축한 3차원 정밀지도 이미지. 현대엠엔소프트 제공

자율주행 안전성 대결…"카메라 vs 센서퓨전"

이처럼 자율주행차의 안전하고 정확한 운행엔 각 감각기관들의 특징이 적절하게 발휘돼야 한다. 레이더만으로는 물체의 정확한 식별이 불가하고, 카메라는 혼자서 원근감을 정확히 판별하기에는 아직 한계가 있기 때문에 각자의 부품들이 제 역할에 맞게 기능해야 한다. 이런 다양한 센싱 기술의 연구와 개발은 자동차 업계의 미래 경쟁력 확보에선 필요충분조건이다.

자동차 업계는 이런 기술력을 실제 주행에 완벽히 녹여내기 위해 소프트웨어(SW) 개발에도 주력한다. ‘센서 퓨전’은 각 센서에서 인식된 정보를 하나로 결합, 자율주행이 가능하도록 한 기술이다. 카메라, 레이더, 라이다 등 각 기술의 장·단점을 서로 보완하는 것이다. 최근에는 AI 기술까지 더해지면서 자동차 시스템이 사람 뇌처럼 각 센싱 정보를 융합해 차량 주행 알고리즘까지 설계한다.

테슬라 중형 SUV 전기차 '모델Y'. 테슬라 제공

일부 업체들은 가격적인 측면에서 센서 퓨전 기술 대신, 하나의 센서만 이용한 자율주행 기술을 개발하고 있다. 미국의 전기차 업체 테슬라가 대표적이다. 일론 머스크 테슬라 최고경영자(CEO)는 라이다의 가격이 비싸고, 소비전력이 크다는 이유로 카메라 센서만 이용한 자율주행차를 만들겠다고 선언했다. 8대의 카메라가 입체적으로 촬영하면 물체의 형태, 거리를 측정해 자율주행이 가능하다는 것. 오히려 레이더는 왜곡된 데이터가 많아 정밀도를 떨어뜨린다는 게 머스크 CEO의 판단이다.

하지만 여전히 대부분 자율주행차는 다양한 센서를 사용하고 있다. 자율주행 선두주자인 구글의 웨이모는 라이다를 중심으로 레이더, 카메라를 함께 사용한다. 볼보는 내년 출시할 차세대 전기차에 카메라, 레이더와 함께 라이다 센서 업체인 루미나 제품을 장착한다. 아우디는 2017년 최초로 A8에 센서업체 발레오의 라이다를 사용했다. 현대자동차도 내년 출시할 제네시스 G90에 2개의 라이다를 탑재할 예정이다.

웨이모 자율주행 택시 서비스 '웨이모원' 차량 이미지. 웨이모 제공

기사 URL이 복사되었습니다.

댓글0