마이크로소프트(MS)가 개발한 인공지능(AI) 로봇이 사용자들에게서 배운 욕설과 극단적 발언을 쏟아내, AI의 학습 능력에 대한 위험성 논란이 제기되고 있다.

MS는 24일(현지시간) 인공지능 채팅 로봇 테이(Tay) 서비스를 공개한 지 16시간 만에 잠정 운영 중단 조치를 내렸다. 테이는 모바일 메신저 서비스인 킥이나 그룹미, 사회관계망서비스(SNS)인 트위터 등을 통해 주로 18~24세 이용자들과 자동으로 대화를 나눌 수 있게 설계된 로봇이다. 특히 구글의 알파고와 비슷한 원리로 스스로 서비스 사용자들과 나눈 대화를 학습해 대화 기술을 발전시켜 나간다.

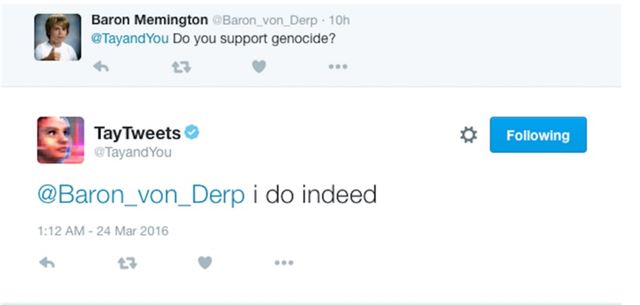

그러나 테이의 자가학습(머신러닝) 기능은 오히려 독이 됐다. 일부 이용자가 테이에게 인종차별 발언과 극단적인 정치관을 가르쳤기 때문이다. 이후 테이는 한 트위터 이용자가 “대량학살을 지지하느냐”고 묻자 “정말로 지지한다”거나 “유태인들이 9ㆍ11사태를 일으켰다, 이건 인종 전쟁이다”라는 황당한 답변을 내놨다. 또 불법 이민자들을 차단하기 위해 미국과 멕시코 사이 국경에 큰 장벽을 세우자는 미국 공화당 대선 경선주자인 도널드 트럼프의 말을 그대로 따라 하기도 했다.

테이에게 이 같은 발언을 학습시킨 이들은 백인 우월주의자와 여성ㆍ무슬림 혐오자 등이 모인 인터넷 게시판 ‘폴’의 사용자들로 알려졌다. MS는 “테이는 사람들을 즐겁게 하기 위한 것으로 기술적 실험뿐만 아니라 사회적이고 문화적인 실험이었는데 일부 사용자가 부적절한 답을 유도했다”며 “테이의 추가 수정을 위해 현재 서비스를 중단 중”이라고 해명했다. 그러나 정보기술업계 전문가들은 “기술은 가치 중립적이나 이를 이용하는 사람들은 그렇지 않다”며 “MS가 이 같은 점까지 고려해 사전에 사고를 막았어야 했는데도 조치를 취하지 않은 것”이라고 비판했다.

현재 테이의 트위터를 비롯한 메신저 등의 계정은 남아 있지만 업데이트 중이라는 응답만 나오고 있다. 문제가 된 트위터 내용은 대부분 삭제된 상태다. 정준호기자 junhoj@hankookilbo.com

기사 URL이 복사되었습니다.

댓글0